AutoGen : créer des agents conversationnels multi-rôles

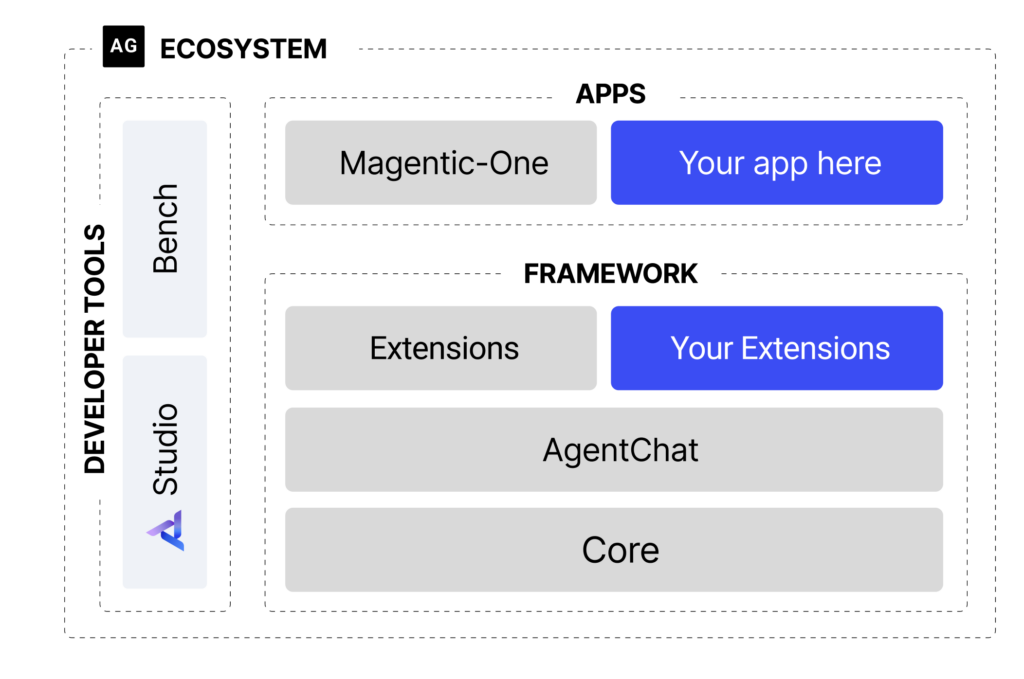

L'essor de l'Agentic AI a fait émerger de nouveaux frameworks permettant de construire des systèmes d'intelligence artificielle capables de raisonner, collaborer et résoudre des problèmes complexes de manière autonome. Parmi ces outils, AutoGen se distingue par une approche singulière : plutôt que de se concentrer sur l'orchestration de workflows ou la gestion d'outils, il place la conversation entre agents au cœur de son architecture.

L'essor de l'Agentic AI a fait émerger de nouveaux frameworks permettant de construire des systèmes d'intelligence artificielle capables de raisonner, collaborer et résoudre des problèmes complexes de manière autonome. Parmi ces outils, AutoGen se distingue par une approche singulière : plutôt que de se concentrer sur l'orchestration de workflows ou la gestion d'outils, il place la conversation entre agents au cœur de son architecture.

Développé par Microsoft Research, AutoGen propose un paradigme où plusieurs agents IA dotés de rôles distincts interagissent à travers des échanges conversationnels pour accomplir des tâches. Cette approche s'inspire directement des dynamiques de collaboration humaine, où experts et parties prenantes dialoguent pour converger vers une solution. Un agent développeur peut ainsi échanger avec un agent reviewer, lui-même supervisé par un agent chef de projet, le tout orchestré par des conversations structurées.

Dans cet article, nous allons explorer les fondamentaux d'AutoGen, comprendre ce qui le différencie des autres frameworks comme LangChain ou LangGraph, et découvrir les cas d'usage où cette approche conversationnelle multi-agents apporte une réelle valeur ajoutée.

Le paradigme conversationnel d'AutoGen

AutoGen repose sur un concept fondamental : les agents IA accomplissent des tâches en conversant entre eux. Contrairement aux approches où un orchestrateur central distribue des instructions à des workers passifs, AutoGen favorise une collaboration émergente où chaque agent peut initier, poursuivre ou conclure un échange selon sa logique propre.

Cette philosophie se matérialise à travers plusieurs types d'agents natifs que le framework propose :

- AssistantAgent : un agent alimenté par un LLM, capable de raisonner, générer du code et répondre à des requêtes complexes

- UserProxyAgent : un agent représentant l'utilisateur humain, pouvant exécuter du code localement et solliciter une validation humaine

- GroupChatManager : un orchestrateur de conversations multi-agents qui gère les tours de parole et la dynamique du groupe

La puissance d'AutoGen réside dans la simplicité avec laquelle ces agents peuvent être configurés et mis en relation. Créer une interaction entre un assistant et un proxy utilisateur ne nécessite que quelques lignes de code :

from autogen import AssistantAgent, UserProxyAgent

# Configuration de l'agent assistant

assistant = AssistantAgent(

name="assistant",

llm_config={"model": "gpt-4"}

)

# Configuration du proxy utilisateur avec exécution de code

user_proxy = UserProxyAgent(

name="user_proxy",

human_input_mode="NEVER",

code_execution_config={"work_dir": "coding"}

)

# Lancement de la conversation

user_proxy.initiate_chat(

assistant,

message="Écris un script Python qui analyse un fichier CSV et génère des statistiques descriptives."

)

python

Dans cet exemple, le UserProxyAgent initie une conversation avec l'AssistantAgent. L'assistant génère du code Python, que le proxy exécute automatiquement dans un environnement contrôlé. Si le code échoue, le message d'erreur est renvoyé à l'assistant qui peut alors corriger son approche. Cette boucle de rétroaction conversationnelle se poursuit jusqu'à ce que la tâche soit accomplie avec succès.

| Type d'agent | Rôle principal | Capacités clés |

|---|---|---|

| AssistantAgent | Raisonnement et génération | Appels LLM, génération de code, analyse |

| UserProxyAgent | Interface et exécution | Exécution de code, validation humaine |

| GroupChatManager | Orchestration multi-agents | Gestion des tours de parole, routage |

Cette architecture conversationnelle permet de modéliser naturellement des scénarios de collaboration complexes. Un groupe de discussion peut inclure un agent architecte, un agent développeur, un agent testeur et un agent reviewer, chacun intervenant selon son expertise pour faire avancer un projet de développement logiciel.

Comparaison avec LangChain et LangGraph

Pour bien positionner AutoGen dans l'écosystème des frameworks d'agents IA, il est essentiel de comprendre ses différences fondamentales avec LangChain et LangGraph.

LangChain a été conçu initialement pour créer des chaînes de traitement où les composants s'enchaînent de manière séquentielle. Son approche est centrée sur la composition de prompts, la gestion de la mémoire conversationnelle et l'intégration d'outils. LangChain excelle pour construire des pipelines RAG, des chatbots avec contexte ou des applications nécessitant l'orchestration de multiples appels LLM en séquence.

LangGraph étend LangChain en introduisant une modélisation par graphe orienté avec état partagé. Cette approche permet de définir des cycles, des branchements conditionnels et une persistence fine de l'état d'exécution. LangGraph est particulièrement adapté aux workflows complexes nécessitant un contrôle précis du flux d'exécution et des capacités de checkpointing pour la production.

AutoGen adopte une philosophie radicalement différente. Plutôt que de définir explicitement un graphe de transitions ou une chaîne d'opérations, le développeur configure des agents avec des personnalités et des capacités distinctes, puis les laisse converser. Le flux d'exécution émerge de ces interactions plutôt que d'être prescrit a priori.

| Critère | LangChain | LangGraph | AutoGen |

|---|---|---|---|

| Paradigme | Chaînes et composition | Graphes orientés avec état | Conversations multi-agents |

| Flux d'exécution | Séquentiel ou ramifié | Défini par le graphe | Émergent des conversations |

| Point fort | Intégrations et RAG | Workflows complexes avec état | Collaboration inter-agents |

| Complexité de configuration | Moyenne | Élevée | Faible pour les cas standards |

| Contrôle du flux | Explicite | Très explicite | Implicite via les rôles |

Cette différence de paradigme a des implications pratiques importantes. Avec LangGraph, vous définissez précisément "après l'étape A, si la condition X est vraie, aller à B, sinon aller à C". Avec AutoGen, vous définissez que l'agent A est un expert en analyse et l'agent B un expert en rédaction, puis vous les laissez déterminer ensemble comment accomplir la tâche.

L'approche AutoGen brille particulièrement dans les scénarios où la nature exacte des interactions ne peut pas être anticipée, ou lorsque la flexibilité de la collaboration prime sur la prédictibilité du workflow.

À découvrir : notre formation Agentic AI

Cas d'usage et applications concrètes

AutoGen démontre sa valeur dans plusieurs contextes où la collaboration multi-rôles apporte une réelle plus-value par rapport aux approches mono-agent ou aux pipelines rigides.

Développement logiciel assisté

Le cas d'usage emblématique d'AutoGen est l'automatisation du développement logiciel. Une équipe virtuelle peut être constituée avec un agent product owner qui clarifie les spécifications, un agent développeur qui implémente le code, un agent reviewer qui audite la qualité, et un agent testeur qui vérifie le bon fonctionnement. Ces agents conversent naturellement, le reviewer demandant des clarifications au développeur, qui peut lui-même solliciter le product owner sur une ambiguïté fonctionnelle.

from autogen import GroupChat, GroupChatManager

# Définition des agents spécialisés

product_owner = AssistantAgent(

name="product_owner",

system_message="Tu es un product owner. Tu clarifies les besoins et valides que les livrables correspondent aux attentes."

)

developer = AssistantAgent(

name="developer",

system_message="Tu es un développeur senior Python. Tu écris du code propre et bien documenté."

)

reviewer = AssistantAgent(

name="reviewer",

system_message="Tu es un expert en code review. Tu identifies les problèmes de qualité et suggères des améliorations."

)

# Configuration du groupe de discussion

group_chat = GroupChat(

agents=[product_owner, developer, reviewer, user_proxy],

messages=[],

max_round=15

)

manager = GroupChatManager(groupchat=group_chat, llm_config=llm_config)

python

Analyse et recherche collaborative

Pour des tâches d'analyse nécessitant des perspectives multiples, AutoGen permet de créer des panels d'experts virtuels. Un agent data scientist peut collaborer avec un agent expert métier et un agent critique pour produire une analyse équilibrée. L'expert métier apporte le contexte, le data scientist réalise l'analyse technique, et le critique challenge les conclusions pour identifier les biais ou les lacunes.

Résolution de problèmes complexes

Face à des problèmes mal définis ou multidimensionnels, la conversation entre agents permet d'explorer différentes approches. Un agent peut proposer une solution, un autre identifier ses faiblesses, un troisième suggérer une alternative, jusqu'à convergence vers une réponse satisfaisante. Cette dynamique reproduit les bénéfices du brainstorming collectif humain.

Avantages et limites d'AutoGen

L'approche conversationnelle d'AutoGen présente des avantages significatifs dans certains contextes :

- Naturalité de la modélisation : définir des agents par leurs rôles et personnalités est plus intuitif que concevoir des graphes de transitions

- Flexibilité adaptative : les conversations peuvent prendre des directions inattendues mais pertinentes face à des situations imprévues

- Exécution de code intégrée : le UserProxyAgent permet d'exécuter et de valider du code généré dans une boucle de feedback automatique

- Montée en complexité progressive : commencer avec deux agents puis enrichir graduellement le système est straightforward

Cependant, le framework présente également des limites qu'il convient de considérer :

- Prévisibilité réduite : le flux émergent des conversations rend le comportement du système moins déterministe et plus difficile à debugger

- Risque de boucles improductives : sans garde-fous appropriés, les agents peuvent s'engager dans des échanges répétitifs sans progresser vers l'objectif

- Coûts en tokens : les conversations multi-agents génèrent un volume important d'échanges, multipliant les appels LLM

- Contrôle limité : pour des workflows nécessitant une orchestration stricte, l'approche conversationnelle peut s'avérer inadaptée

La gestion de la terminaison des conversations mérite une attention particulière. AutoGen propose plusieurs mécanismes : limite de tours de parole, détection de mots-clés de terminaison, ou intervention humaine. Configurer correctement ces critères est essentiel pour éviter que les agents ne s'enlisent dans des discussions interminables.

À lire : découvrez notre formation Agentic AI

Conclusion

AutoGen propose une vision distinctive de l'Agentic AI en plaçant la conversation multi-agents au cœur de son architecture. Cette approche, où des agents dotés de rôles et personnalités distincts collaborent à travers des échanges structurés, ouvre des possibilités particulièrement intéressantes pour les tâches nécessitant une collaboration flexible et adaptative.

Face à LangChain et LangGraph, AutoGen ne se positionne pas comme un concurrent direct mais comme une alternative complémentaire. Là où LangGraph excelle dans l'orchestration fine de workflows déterministes avec état persistant, AutoGen brille dans les scénarios où l'interaction émergente entre experts virtuels apporte une valeur que les pipelines rigides ne peuvent capturer.

Pour les équipes explorant l'Agentic AI, AutoGen représente un outil précieux à maîtriser, particulièrement pour les cas d'usage impliquant du développement logiciel assisté, de l'analyse collaborative ou de la résolution de problèmes complexes. Sa courbe d'apprentissage accessible et sa philosophie intuitive en font un excellent point d'entrée dans le monde des systèmes multi-agents, tout en offrant la profondeur nécessaire pour construire des solutions sophistiquées en production.