Ollama : exécuter des LLM en local sur son propre PC

L'utilisation des LLM a longtemps été synonyme de connexion Internet et de dépendance aux API cloud. Pour chaque requête envoyée à ChatGPT ou Claude, vos données transitent par des serveurs distants, avec tout ce que cela implique en termes de confidentialité, de latence et de coûts récurrents. Cette situation a conduit de nombreux développeurs et entreprises à chercher des alternatives permettant d'exécuter des LLM directement sur leur propre machine.

L'utilisation des modèles de langage a longtemps été synonyme de connexion Internet et de dépendance aux API cloud. Pour chaque requête envoyée à ChatGPT ou Claude, vos données transitent par des serveurs distants, avec tout ce que cela implique en termes de confidentialité, de latence et de coûts récurrents. Cette situation a conduit de nombreux développeurs et entreprises à chercher des alternatives permettant d'exécuter des LLM directement sur leur propre machine.

C'est précisément ce que propose Ollama. Cet outil open source permet de télécharger, gérer et exécuter des modèles de langage en local, sans aucune connexion Internet une fois le modèle installé. Que vous souhaitiez protéger des données sensibles, expérimenter sans contrainte de facturation, ou simplement travailler hors ligne, Ollama transforme votre ordinateur en véritable serveur d'IA personnel.

Dans cet article, nous allons explorer ce qu'est Ollama, comprendre ce qui le distingue des solutions cloud traditionnelles, et découvrir comment l'utiliser concrètement pour tirer parti des LLM open source les plus performants.

Pourquoi exécuter des LLM en local ?

L'engouement pour l'exécution locale de LLM répond à des préoccupations concrètes que les API cloud ne peuvent pas adresser. Comprendre ces enjeux permet de mieux saisir l'intérêt d'un outil comme Ollama.

La confidentialité des données constitue souvent la motivation principale. Lorsque vous utilisez ChatGPT ou Claude via leurs API, chaque prompt que vous envoyez transite par les serveurs du fournisseur. Pour des cas d'usage impliquant du code propriétaire, des documents internes, des données clients ou des informations médicales, cette exposition peut être inacceptable, voire contraire aux réglementations en vigueur. Avec un LLM local, vos données ne quittent jamais votre machine.

Le contrôle des coûts représente un autre avantage significatif. Les API comme GPT-4 ou Claude facturent au token, et les coûts peuvent grimper rapidement pour des applications intensives. Un modèle exécuté localement, une fois téléchargé, peut être utilisé sans limite et sans facturation additionnelle. Pour du prototypage, de l'expérimentation ou des usages personnels, cette différence est substantielle.

| Aspect | API Cloud (ChatGPT, Claude) | Ollama (local) |

|---|---|---|

| Confidentialité | Données envoyées au fournisseur | Données restent sur votre machine |

| Coût d'utilisation | Facturation au token | Gratuit après téléchargement |

| Connexion Internet | Obligatoire | Non requise |

| Latence | Variable (réseau) | Dépend uniquement du hardware |

| Choix des modèles | Limité au catalogue du fournisseur | Tous les modèles open weights |

| Personnalisation | Limitée | Fine-tuning et configuration libres |

Enfin, la disponibilité hors ligne et l'indépendance technique séduisent de nombreux utilisateurs. Travailler dans un avion, dans une zone sans réseau, ou simplement sans dépendre de la disponibilité d'un service tiers devient possible. Cette autonomie est particulièrement appréciée des développeurs qui intègrent des LLM dans leurs workflows quotidiens.

Qu'est-ce qu'Ollama et comment ça fonctionne ?

Ollama est un outil open source qui simplifie radicalement l'exécution de LLM en local. Là où faire tourner un modèle comme Llama 3 nécessitait traditionnellement de jongler avec des dépendances Python, des configurations CUDA complexes et des scripts de chargement, Ollama encapsule toute cette complexité dans une interface minimaliste.

Le principe est simple : Ollama fonctionne comme un gestionnaire de modèles couplé à un serveur d'inférence. Vous téléchargez un modèle en une commande, et il devient immédiatement disponible via une API locale ou une interface en ligne de commande. Sous le capot, Ollama utilise llama.cpp, une implémentation C++ hautement optimisée qui permet d'exécuter des modèles sur CPU comme sur GPU, avec une consommation mémoire maîtrisée grâce à la quantification.

L'installation est remarquablement simple. Sur macOS et Linux, une seule commande suffit :

curl -fsSL https://ollama.com/install.sh | sh

bash

Sur Windows, un installateur classique est disponible. Une fois Ollama installé, le téléchargement et l'exécution d'un modèle se font en une ligne :

# Télécharger et lancer Llama 3.1 8B

ollama run llama3.1

# Télécharger et lancer Mistral 7B

ollama run mistral

# Lister les modèles installés

ollama list

bash

La première exécution télécharge le modèle (plusieurs gigaoctets selon la taille), puis lance une session interactive où vous pouvez dialoguer directement avec le LLM. Les modèles sont stockés localement et réutilisés lors des sessions suivantes.

Ollama propose un catalogue riche de modèles pré-configurés, incluant les références du marché open source :

- Llama 3.1 (8B, 70B, 405B) : les modèles phares de Meta, excellents en raisonnement et génération de code

- Mistral et Mixtral : modèles français performants, particulièrement efficaces pour leur taille

- Phi-3 : modèles compacts de Microsoft, optimisés pour le raisonnement

- Qwen 2 : modèles d'Alibaba avec un excellent support multilingue

- CodeLlama et DeepSeek Coder : modèles spécialisés pour la génération de code

- Gemma : modèles légers de Google, adaptés aux machines modestes

À découvrir : notre formation LLM Engineering

Utiliser Ollama au quotidien

Au-delà de l'interface conversationnelle basique, Ollama offre plusieurs modes d'utilisation qui s'adaptent à différents besoins.

L'API REST pour l'intégration applicative

Ollama expose automatiquement une API REST locale sur le port 11434. Cette API permet d'intégrer les capacités du LLM dans n'importe quelle application :

import requests

response = requests.post(

"http://localhost:11434/api/generate",

json={

"model": "llama3.1",

"prompt": "Explique le concept de récursivité en programmation.",

"stream": False

}

)

print(response.json()["response"])

python

Pour les développeurs habitués à l'API OpenAI, Ollama propose également un endpoint compatible qui permet d'utiliser le SDK OpenAI standard :

from openai import OpenAI

client = OpenAI(

base_url="http://localhost:11434/v1",

api_key="ollama" # Valeur arbitraire, non vérifiée

)

response = client.chat.completions.create(

model="llama3.1",

messages=[

{"role": "user", "content": "Écris une fonction Python pour calculer la suite de Fibonacci."}

]

)

print(response.choices[0].message.content)

python

Cette compatibilité facilite grandement la migration d'applications existantes vers une exécution locale, ou le développement d'applications hybrides utilisant parfois le cloud, parfois le local.

Personnalisation avec les Modelfiles

Ollama permet de créer des versions personnalisées de modèles via les Modelfiles, un format déclaratif inspiré des Dockerfiles. Vous pouvez ainsi configurer un system prompt par défaut, ajuster les paramètres de génération, ou même intégrer vos propres modèles fine-tunés.

Cette fonctionnalité est particulièrement utile pour créer des assistants spécialisés adaptés à des domaines métier spécifiques, sans avoir à répéter le même system prompt à chaque session.

Cas d'usage et configurations recommandées

Ollama s'adapte à une variété de scénarios, chacun avec ses propres exigences matérielles et choix de modèles.

Pour un usage personnel sur laptop, les modèles de 7-8 milliards de paramètres quantifiés en 4 bits (comme llama3.1:8b ou mistral:7b) fonctionnent confortablement avec 8 Go de RAM. Ils conviennent parfaitement pour l'assistance à la rédaction, la génération de code simple, ou l'apprentissage des concepts d'IA. Sur un MacBook avec puce Apple Silicon, les performances sont particulièrement bonnes grâce à l'optimisation Metal.

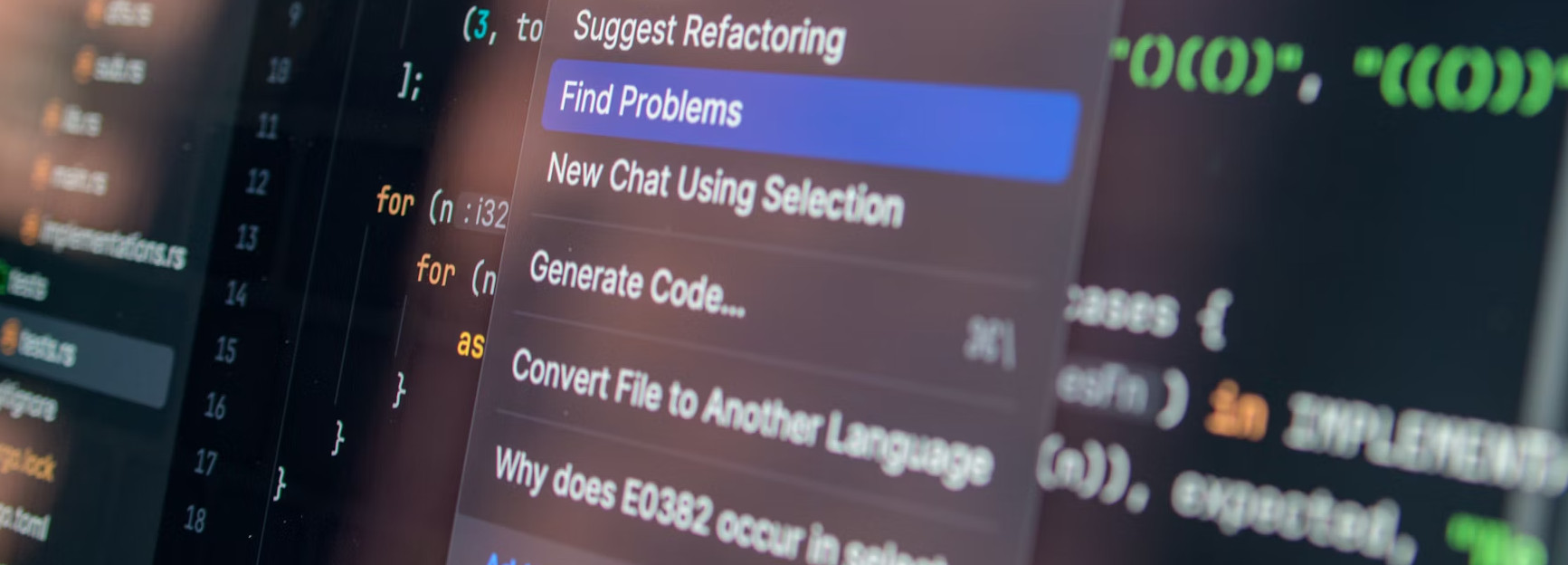

Pour du développement logiciel, les modèles spécialisés en code comme CodeLlama ou DeepSeek Coder offrent de meilleurs résultats que les modèles généralistes. L'intégration avec des éditeurs comme VS Code (via l'extension Continue) ou des outils comme Claude Code permet de bénéficier d'une assistance au coding sans envoyer votre code propriétaire sur Internet.

Pour des applications d'entreprise impliquant des données sensibles, Ollama peut servir de backend local pour des systèmes de RAG où les documents ne doivent pas quitter l'infrastructure interne. Combiné avec des frameworks comme LangChain ou LlamaIndex, il devient possible de construire des assistants documentaires entièrement privés.

| Configuration | RAM minimale | Modèle recommandé | Cas d'usage |

|---|---|---|---|

| Laptop standard | 8 Go | mistral:7b, phi3 | Usage personnel, expérimentation |

| Workstation | 16-32 Go | llama3.1:8b, mixtral | Développement, RAG local |

| Serveur GPU | 24+ Go VRAM | llama3.1:70b | Applications d'entreprise |

Il est important de noter qu'Ollama n'est pas conçu pour supporter des charges de production importantes avec de nombreux utilisateurs simultanés. Pour ces scénarios, des solutions comme vLLM avec ses optimisations de batching et de gestion mémoire seront plus appropriées. Ollama excelle dans les contextes mono-utilisateur ou petit groupe où la simplicité prime sur le throughput.

Conclusion

Ollama représente une démocratisation significative de l'accès aux LLM. En éliminant les barrières techniques traditionnellement associées à l'exécution locale de modèles de langage, il ouvre des possibilités nouvelles pour quiconque souhaite explorer l'IA générative sans dépendre du cloud.

Pour les développeurs et les équipes soucieuses de la confidentialité de leurs données, Ollama offre une alternative crédible aux API commerciales. La possibilité d'expérimenter librement avec différents modèles, de personnaliser leurs comportements, et de les intégrer dans des applications sans contrainte de facturation constitue un avantage considérable pour l'innovation et le prototypage.

L'écosystème des LLM open source continue de progresser rapidement, avec des modèles toujours plus performants et des optimisations permettant de les exécuter sur du matériel de plus en plus accessible. Maîtriser un outil comme Ollama, c'est se donner les moyens de suivre cette évolution et de bénéficier immédiatement des dernières avancées, que ce soit Llama 4, Mistral Large, ou le prochain modèle qui redéfinira les standards du domaine.