Continue : alternative open source à GitHub Copilot

Continue est une extension open source pour VS Code et JetBrains qui offre des fonctionnalités d'assistance au code comparables à GitHub Copilot, avec une différence fondamentale : vous choisissez les modèles que vous utilisez. Que vous souhaitiez connecter l'API d'OpenAI, utiliser Codestral de Mistral, ou faire tourner un LLM en local avec Ollama, Continue s'adapte à votre configuration.

L'assistance au code par l'IA est devenue un standard dans le quotidien des développeurs. GitHub Copilot a largement contribué à démocratiser cette pratique, mais son modèle propriétaire et ses coûts d'abonnement poussent de nombreux professionnels à chercher des alternatives. Pour ceux qui souhaitent garder le contrôle sur leurs outils, leurs données et leurs modèles, Continue s'impose comme une solution de premier plan.

Continue est une extension open source pour VS Code et JetBrains qui offre des fonctionnalités d'assistance au code comparables à GitHub Copilot, avec une différence fondamentale : vous choisissez les modèles que vous utilisez. Que vous souhaitiez connecter l'API d'OpenAI, utiliser Codestral de Mistral, ou faire tourner un LLM en local avec Ollama, Continue s'adapte à votre configuration. Cette flexibilité en fait un outil particulièrement attractif pour les développeurs soucieux de confidentialité ou les équipes ayant des contraintes spécifiques sur leurs environnements de travail.

Dans cet article, nous allons explorer ce qu'est Continue, comprendre ce qui le distingue de GitHub Copilot, et découvrir comment le configurer pour tirer parti des meilleurs modèles de code disponibles.

Continue : une approche open source de l'assistance au code

Continue est né d'un constat simple : les développeurs veulent bénéficier de l'assistance IA sans être enfermés dans un écosystème propriétaire. Lancé en 2023, le projet a rapidement gagné en popularité pour devenir l'une des extensions d'IA les plus téléchargées sur le marketplace VS Code, avec plus de 1,5 million d'installations.

La philosophie de Continue repose sur trois piliers :

- Open source et transparent : le code est entièrement disponible sur GitHub, auditable et modifiable selon vos besoins

- Agnostique aux modèles : aucune dépendance à un fournisseur unique, vous pouvez basculer d'un modèle à l'autre selon vos préférences

- Respect de la vie privée : aucune télémétrie obligatoire, possibilité d'utiliser des modèles locaux pour que votre code ne quitte jamais votre machine

Contrairement à Copilot qui impose ses propres modèles (basés sur OpenAI Codex puis GPT-4), Continue vous laisse orchestrer votre propre stack d'IA. Cette approche modulaire permet d'optimiser chaque fonctionnalité avec le modèle le plus adapté : un modèle rapide pour l'autocomplétion, un modèle plus puissant pour le chat, et potentiellement un modèle spécialisé pour les tâches agentiques.

| Aspect | GitHub Copilot | Continue |

|---|---|---|

| Licence | Propriétaire | Open source (Apache 2.0) |

| Choix des modèles | Imposé par GitHub | Libre (cloud ou local) |

| Coût | 10-39$/mois | Gratuit (+ coût éventuel des API) |

| Données | Transitent par les serveurs GitHub | Selon votre configuration |

| IDE supportés | VS Code, JetBrains, Neovim | VS Code, JetBrains |

| Personnalisation | Limitée | Extensive (prompts, contexte, règles) |

Fonctionnalités et modes d'utilisation

Continue propose un ensemble de fonctionnalités qui couvrent l'essentiel des besoins d'assistance au code, avec des modes d'interaction adaptés à différents contextes de travail.

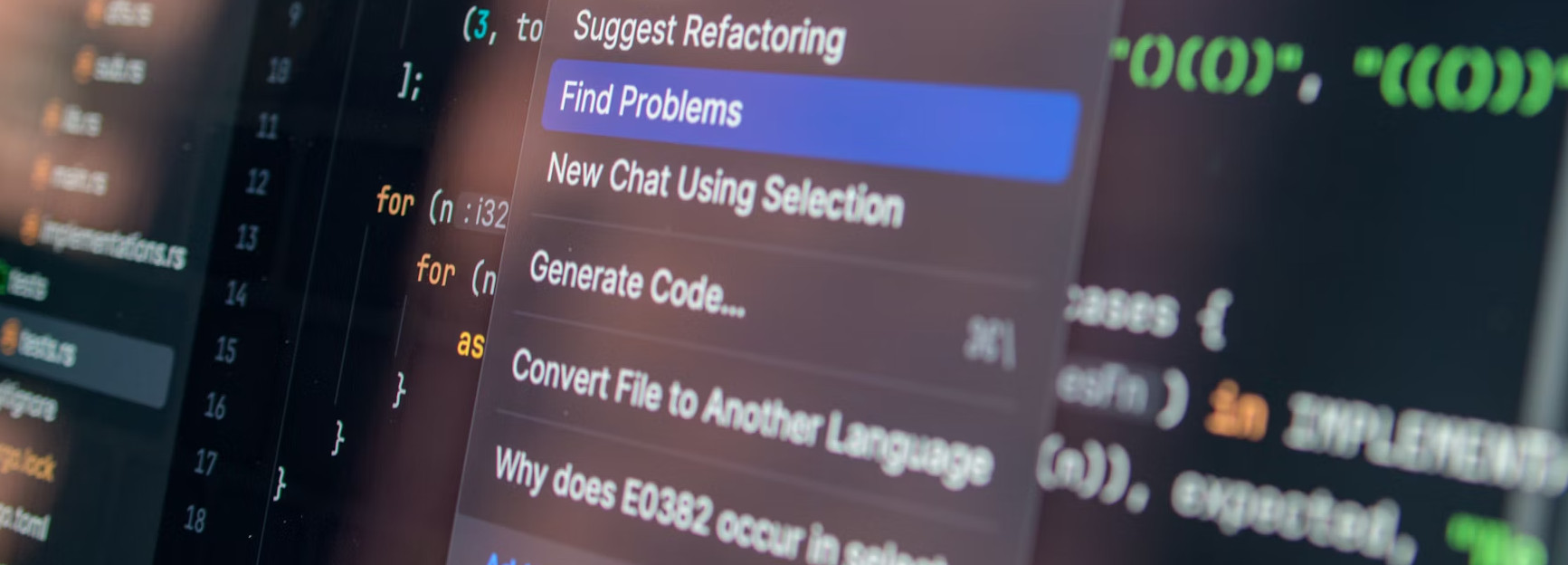

Autocomplétion intelligente

Comme Copilot, Continue offre une autocomplétion en temps réel qui suggère du code pendant que vous tapez. Le système analyse le contexte de votre fichier, les fichiers ouverts, et potentiellement l'ensemble de votre projet pour proposer des complétions pertinentes. Les suggestions apparaissent en gris et s'acceptent d'une simple pression sur Tab.

La particularité de Continue est de permettre l'utilisation de modèles spécifiquement optimisés pour cette tâche. Codestral de Mistral, par exemple, a été conçu pour l'autocomplétion avec une latence minimale et une compréhension fine des patterns de code. Vous pouvez également utiliser des modèles locaux via Ollama pour une autocomplétion sans aucune connexion Internet.

Chat contextuel

Le panneau de chat permet de dialoguer avec le LLM en ayant accès au contexte de votre projet. Vous pouvez poser des questions sur votre code, demander des explications, ou solliciter de l'aide pour résoudre un bug. Le système de références contextuelles est particulièrement puissant :

@file: inclut le contenu d'un fichier spécifique dans le contexte@folder: référence un dossier entier pour des questions architecturales@codebase: permet au modèle de rechercher dans l'ensemble de votre projet@docs: interroge la documentation de bibliothèques tierces@web: effectue une recherche web pour compléter les informations

Cette granularité dans la gestion du contexte permet d'obtenir des réponses plus précises qu'avec un chat générique, tout en contrôlant exactement quelles informations sont envoyées au modèle.

À découvrir : notre formation LLM Engineering

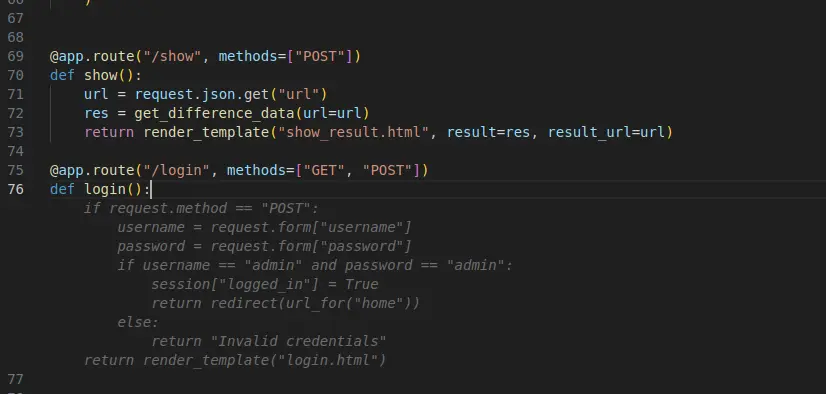

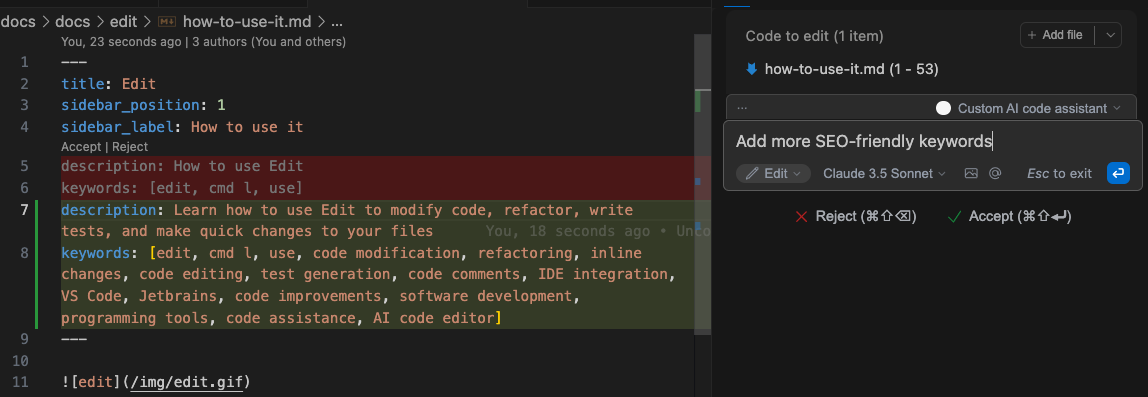

Mode Edit pour les modifications ciblées

Le mode Edit permet de sélectionner une portion de code et de demander une modification en langage naturel. Continue génère alors un diff que vous pouvez accepter ou rejeter. Ce mode est idéal pour :

- Refactoriser une fonction

- Ajouter de la gestion d'erreurs

- Convertir du code d'un style à un autre

- Optimiser une boucle ou une requête

La visualisation des changements sous forme de diff facilite la revue avant application, évitant les modifications non désirées.

Mode Agent pour les tâches complexes

Le mode Agent représente l'évolution la plus récente de l'assistance au code. Dans ce mode, Continue peut planifier et exécuter des tâches multi-étapes de manière autonome : analyser un bug, identifier les fichiers concernés, proposer des corrections, et les appliquer. Similaire à l'approche de Claude Code, ce mode agentique permet de déléguer des tâches plus ambitieuses que la simple complétion de code.

Pour exploiter pleinement ce mode, il est recommandé d'utiliser des modèles de grande capacité comme Claude 3.5 Sonnet, GPT-4o, ou Devstral de Mistral, qui excellent dans le raisonnement multi-étapes.

Configurer Continue avec vos propres modèles

L'un des atouts majeurs de Continue est sa flexibilité de configuration. Le fichier config.json (ou config.yaml) permet de définir précisément quels modèles utiliser pour chaque fonctionnalité.

Utilisation avec Ollama pour un usage local

Pour ceux qui privilégient la confidentialité ou qui travaillent hors ligne, Continue s'intègre parfaitement avec Ollama. Une fois Ollama installé et un modèle téléchargé, la configuration est straightforward :

{

"models": [

{

"title": "Llama 3.1 8B",

"provider": "ollama",

"model": "llama3.1:8b"

}

],

"tabAutocompleteModel": {

"title": "Qwen2.5-Coder",

"provider": "ollama",

"model": "qwen2.5-coder:7b"

}

}

json

Cette configuration utilise Llama 3.1 pour le chat et Qwen2.5-Coder, optimisé pour le code, pour l'autocomplétion. Vos données restent intégralement sur votre machine.

Intégration de Codestral et Devstral de Mistral

Mistral propose deux modèles particulièrement adaptés au développement : Codestral pour l'autocomplétion rapide et Devstral pour les tâches agentiques complexes. Continue permet de les combiner efficacement :

{

"models": [

{

"title": "Devstral",

"provider": "mistral",

"model": "devstral-small-latest",

"apiKey": "VOTRE_CLE_API"

}

],

"tabAutocompleteModel": {

"title": "Codestral",

"provider": "mistral",

"model": "codestral-latest",

"apiKey": "VOTRE_CLE_API"

}

}

json

Codestral offre une latence remarquablement basse pour l'autocomplétion, tandis que Devstral excelle dans la compréhension de contextes larges et les tâches de raisonnement sur le code.

Configuration hybride avancée

La flexibilité de Continue permet de créer des configurations hybrides sophistiquées, utilisant différents fournisseurs selon les besoins :

{

"models": [

{

"title": "Claude 3.5 Sonnet",

"provider": "anthropic",

"model": "claude-3-5-sonnet-20241022",

"apiKey": "VOTRE_CLE_ANTHROPIC"

},

{

"title": "GPT-4o",

"provider": "openai",

"model": "gpt-4o",

"apiKey": "VOTRE_CLE_OPENAI"

},

{

"title": "Llama Local",

"provider": "ollama",

"model": "llama3.1:8b"

}

],

"tabAutocompleteModel": {

"provider": "ollama",

"model": "qwen2.5-coder:7b"

}

}

json

Cette configuration permet de basculer entre modèles cloud puissants pour les tâches complexes et modèles locaux pour le travail quotidien ou sensible.

Personnalisation et bonnes pratiques

Au-delà du choix des modèles, Continue offre des options de personnalisation qui permettent d'adapter finement son comportement à vos besoins.

Les règles personnalisées (custom rules) permettent de définir des instructions persistantes que le modèle suivra dans toutes ses interactions. Vous pouvez par exemple spécifier votre stack technique, vos conventions de code, ou des contraintes de sécurité :

Utilise toujours TypeScript strict avec des types explicites.

Privilégie les fonctions pures et l'immutabilité.

Ajoute des commentaires JSDoc pour les fonctions publiques.

N'utilise jamais `any` comme type.

Le fichier .continuerules à la racine de votre projet permet de définir des règles spécifiques au contexte, automatiquement chargées lors de l'ouverture du projet.

Pour optimiser les performances, plusieurs stratégies sont recommandées :

- Utilisez un modèle léger et rapide pour l'autocomplétion (Codestral, Qwen2.5-Coder local)

- Réservez les modèles puissants (Claude, GPT-4o) pour le chat et les tâches agentiques

- Configurez le contexte automatique pour éviter d'envoyer trop d'informations inutiles

- Profitez des raccourcis clavier pour fluidifier votre workflow

Conclusion

Continue représente une alternative crédible et mature à GitHub Copilot pour les développeurs qui valorisent la flexibilité et le contrôle. En dissociant l'interface utilisateur du choix des modèles, il permet de construire un environnement d'assistance au code véritablement personnalisé.

Pour les équipes travaillant sur du code sensible ou soumises à des contraintes réglementaires, la possibilité d'utiliser des modèles locaux via Ollama constitue un avantage décisif. Pour les développeurs individuels, la combinaison de l'aspect open source et de l'accès aux meilleurs modèles du marché (Claude, GPT-4o, Codestral) offre une flexibilité que Copilot ne peut égaler.

L'écosystème des outils d'IA pour développeurs évolue rapidement, avec l'émergence de modèles toujours plus performants et de nouvelles modalités d'interaction. En adoptant Continue, vous vous donnez la capacité de suivre ces évolutions sans dépendre d'un fournisseur unique. Que le prochain modèle révolutionnaire vienne de Mistral, d'Anthropic, de Meta ou d'un acteur encore inconnu, Continue vous permettra de l'intégrer immédiatement dans votre workflow de développement.