CUDA : tout savoir sur le framework GPU de NVIDIA

Développé par NVIDIA, CUDA (Compute Unified Device Architecture) est le framework qui a permis de transformer les cartes graphiques en véritables accélérateurs de calcul scientifique. Sans cette technologie, l'essor fulgurant de l'IA générative que nous connaissons aujourd'hui n'aurait tout simplement pas été possible. Que vous utilisiez PyTorch, TensorFlow, ou un serveur d'inférence comme vLLM, CUDA constitue la couche fondamentale qui fait le lien entre votre code et la puissance brute du GPU.

Le Deep Learning et les modèles de langage modernes reposent sur une puissance de calcul considérable, impossible à atteindre avec des processeurs traditionnels. Derrière chaque entraînement de LLM, chaque inférence de Stable Diffusion ou chaque session de fine-tuning, se cache une technologie devenue incontournable : CUDA.

Développé par NVIDIA, CUDA (Compute Unified Device Architecture) est le framework qui a permis de transformer les cartes graphiques en véritables accélérateurs de calcul scientifique. Sans cette technologie, l'essor fulgurant de l'IA générative que nous connaissons aujourd'hui n'aurait tout simplement pas été possible. Que vous utilisiez PyTorch, TensorFlow, ou un serveur d'inférence comme vLLM, CUDA constitue la couche fondamentale qui fait le lien entre votre code et la puissance brute du GPU.

Dans cet article, nous allons explorer ce qu'est CUDA, comprendre pourquoi cette technologie est devenue essentielle pour l'IA, et découvrir comment elle fonctionne pour accélérer massivement les calculs.

Qu'est-ce que CUDA et pourquoi est-ce important ?

CUDA est une plateforme de calcul parallèle et un modèle de programmation créés par NVIDIA en 2006. À l'origine, les GPU (Graphics Processing Units) étaient exclusivement conçus pour le rendu graphique des jeux vidéo. CUDA a révolutionné cette approche en permettant aux développeurs d'utiliser ces processeurs massivement parallèles pour des calculs généraux, bien au-delà du simple affichage d'images.

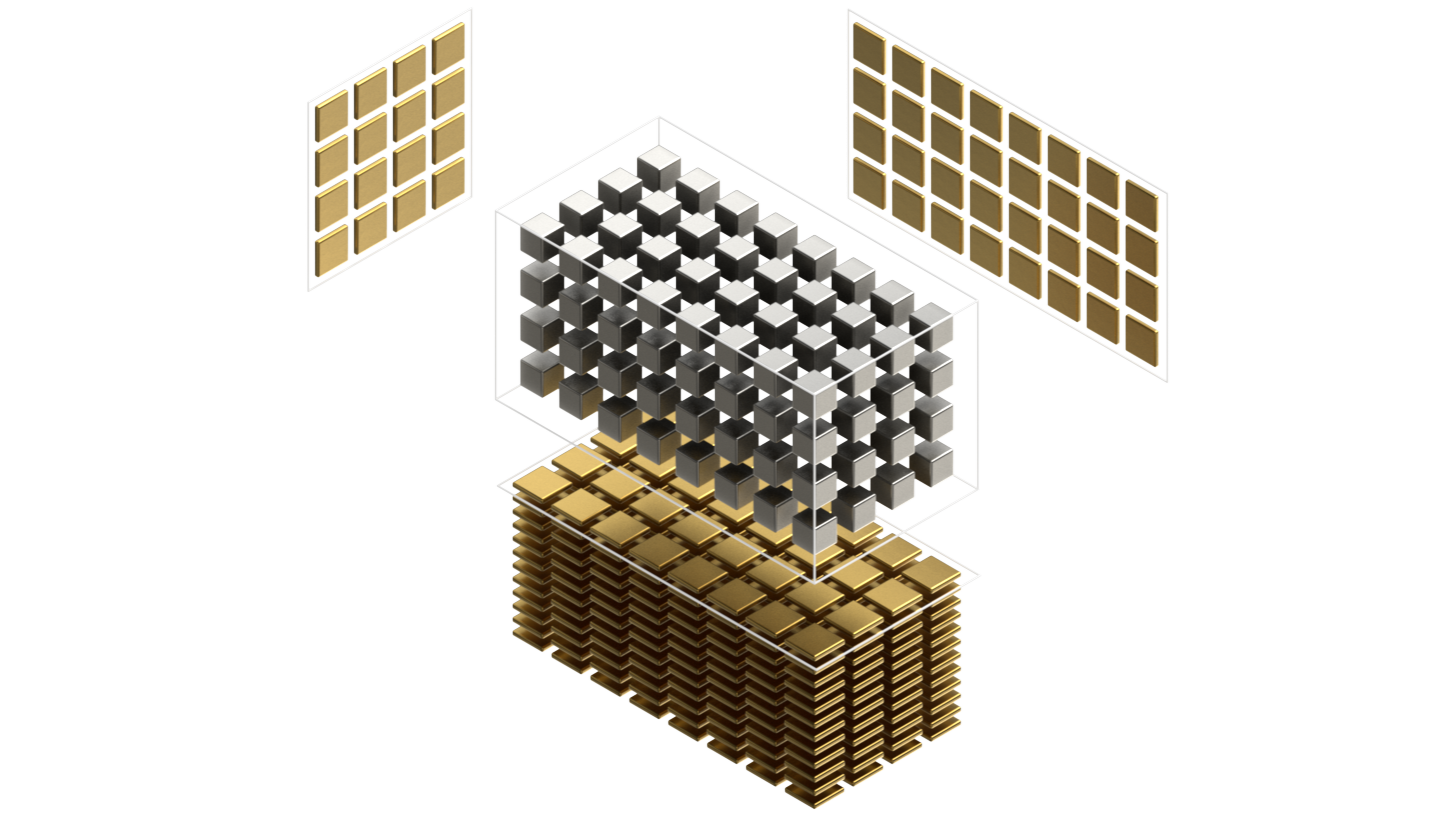

L'idée fondamentale est simple : là où un CPU dispose de quelques cœurs très puissants (généralement 4 à 16 pour un processeur grand public), un GPU moderne embarque plusieurs milliers de cœurs conçus pour exécuter des opérations simultanément. Une carte NVIDIA RTX 4090, par exemple, possède plus de 16 000 cœurs CUDA. Cette architecture est parfaitement adaptée aux opérations matricielles qui constituent l'essentiel des calculs en deep learning.

Concrètement, CUDA permet de :

- Paralléliser massivement les calculs : une multiplication matricielle qui prendrait plusieurs secondes sur CPU peut s'exécuter en quelques millisecondes sur GPU.

- Accéder directement à la mémoire GPU (VRAM) : les données restent sur le GPU, évitant les transferts coûteux entre RAM et VRAM.

- Utiliser des bibliothèques optimisées : cuBLAS pour l'algèbre linéaire, cuDNN pour les réseaux de neurones, ou encore cuFFT pour les transformées de Fourier.

| Caractéristique | CPU | GPU avec CUDA |

|---|---|---|

| Nombre de cœurs | 4-64 | 1 000-16 000+ |

| Type d'opérations | Séquentielles complexes | Parallèles simples |

| Latence par opération | Très faible | Modérée |

| Débit global | Modéré | Très élevé |

| Usage optimal | Logique, branchements | Calcul matriciel massif |

Cette différence architecturale explique pourquoi l'entraînement d'un modèle comme GPT prendrait des années sur CPU, mais seulement quelques semaines sur un cluster de GPU. CUDA est devenu le standard de facto pour l'accélération GPU en IA, à tel point que la compatibilité CUDA est souvent le premier critère de choix pour du matériel destiné au machine learning.

Comment CUDA accélère les calculs pour l'IA

Pour comprendre l'impact de CUDA sur les performances, il faut d'abord saisir la nature des calculs en deep learning. Un réseau de neurones, qu'il s'agisse d'un simple perceptron ou d'un LLM de plusieurs milliards de paramètres, repose essentiellement sur des opérations d'algèbre linéaire : multiplications de matrices, additions de vecteurs, et applications de fonctions d'activation.

À découvrir : notre formation LLM Engineering

Prenons l'exemple d'une multiplication matricielle entre deux matrices de dimension 4096×4096, opération courante lors d'une passe forward dans un transformer. Sur CPU, cette opération implique environ 137 milliards d'opérations arithmétiques, exécutées de manière relativement séquentielle. Sur GPU avec CUDA, ces mêmes calculs sont distribués sur des milliers de cœurs qui travaillent simultanément, réduisant le temps d'exécution de plusieurs ordres de grandeur.

Le modèle de programmation CUDA

CUDA introduit un modèle de programmation basé sur les kernels, des fonctions qui s'exécutent en parallèle sur le GPU. Lorsqu'un kernel est lancé, il est exécuté par des milliers de threads organisés en blocs, eux-mêmes regroupés en grilles. Cette hiérarchie permet de structurer efficacement le parallélisme :

- Threads : unité d'exécution la plus fine, chaque thread effectue une portion du calcul.

- Blocs : groupes de threads qui peuvent partager de la mémoire locale rapide.

- Grilles : ensemble de blocs couvrant l'intégralité du problème à résoudre.

En pratique, les développeurs d'applications d'IA n'écrivent que rarement des kernels CUDA directement. Des frameworks comme PyTorch ou TensorFlow encapsulent cette complexité et appellent automatiquement les kernels optimisés de bibliothèques comme cuDNN (CUDA Deep Neural Network library). Cette bibliothèque contient des implémentations ultra-optimisées des opérations de deep learning : convolutions, normalisation par batch, fonctions d'attention, et bien d'autres.

Les Tensor Cores : l'accélération spécialisée

Depuis l'architecture Volta (2017), NVIDIA a introduit les Tensor Cores, des unités de calcul spécialisées pour les opérations matricielles en précision mixte. Contrairement aux cœurs CUDA classiques qui traitent une opération à la fois, les Tensor Cores peuvent effectuer une multiplication-accumulation de matrices 4×4 en un seul cycle d'horloge.

Cette innovation a permis des gains de performance considérables, notamment pour l'entraînement et l'inférence de LLM. Les Tensor Cores supportent plusieurs formats numériques :

- FP16 (half precision) : réduit de moitié l'utilisation mémoire par rapport au FP32.

- BF16 (bfloat16) : conserve la plage dynamique du FP32 avec moins de précision.

- INT8 et FP8 : pour l'inférence quantifiée, offrant des performances encore supérieures.

C'est grâce à ces optimisations matérielles, accessibles via CUDA, que des serveurs d'inférence comme vLLM peuvent atteindre des débits de plusieurs dizaines de tokens par seconde, même sur des modèles de plusieurs dizaines de milliards de paramètres.

L'écosystème CUDA et ses alternatives

CUDA ne se limite pas à une simple interface de programmation : c'est un écosystème complet qui englobe des bibliothèques, des outils de développement et de profilage, ainsi qu'un vaste ensemble de ressources communautaires.

Les bibliothèques essentielles

L'écosystème CUDA comprend plusieurs bibliothèques qui couvrent différents domaines d'application :

- cuBLAS : implémentation optimisée des opérations d'algèbre linéaire (BLAS) sur GPU.

- cuDNN : primitives optimisées pour le deep learning, utilisées par PyTorch et TensorFlow.

- cuFFT : transformées de Fourier rapides, essentielles pour le traitement du signal.

- NCCL : communication multi-GPU optimisée pour l'entraînement distribué.

- TensorRT : optimisation et déploiement de modèles d'inférence avec quantification automatique.

Ces bibliothèques sont le fruit de plusieurs années d'optimisation par les ingénieurs NVIDIA et représentent un avantage compétitif majeur. Lorsqu'un développeur utilise PyTorch sur GPU NVIDIA, chaque opération tensorielle est automatiquement routée vers l'implémentation CUDA la plus performante disponible.

La question des alternatives

La domination de CUDA dans le domaine de l'IA soulève régulièrement des questions sur la dépendance à un seul fournisseur. Plusieurs alternatives existent, mais aucune n'a atteint le même niveau de maturité :

- ROCm (AMD) : équivalent open source pour les GPU AMD, compatible avec une partie de l'écosystème via HIP (traducteur CUDA vers ROCm).

- oneAPI (Intel) : framework unifié pour CPU, GPU et accélérateurs Intel.

- OpenCL : standard ouvert multi-plateforme, mais moins optimisé et moins adopté pour le deep learning.

- Metal (Apple) : framework pour les GPU Apple Silicon, utilisé par MLX.

En pratique, la majorité des infrastructures d'IA en production reposent sur CUDA. Les frameworks majeurs (PyTorch, TensorFlow, JAX) offrent leur meilleur support et leurs meilleures performances sur matériel NVIDIA. Cette situation crée un effet de réseau : plus CUDA est utilisé, plus les optimisations se concentrent sur cette plateforme, renforçant son avantage.

Installer et configurer CUDA

L'installation de CUDA peut sembler intimidante au premier abord, mais elle suit un processus relativement standardisé. Avant de se lancer, il est important de comprendre les différents composants impliqués.

Les composants à installer

Un environnement CUDA fonctionnel nécessite trois éléments principaux :

- Le driver NVIDIA : pilote système permettant la communication entre le système d'exploitation et le GPU. Il doit être compatible avec la version de CUDA souhaitée.

- Le CUDA Toolkit : ensemble comprenant le compilateur nvcc, les bibliothèques runtime, et les outils de développement.

- cuDNN : bibliothèque additionnelle pour le deep learning, à télécharger séparément depuis le site NVIDIA Developer.

La compatibilité entre ces composants est cruciale. Chaque version de PyTorch ou TensorFlow est compilée pour une version spécifique de CUDA. Utiliser une version incompatible peut entraîner des erreurs silencieuses ou des crashs. Il est donc recommandé de consulter la matrice de compatibilité du framework utilisé avant l'installation.

Bonnes pratiques d'installation

Plutôt que d'installer CUDA directement sur le système, de nombreux praticiens préfèrent utiliser des environnements conteneurisés. Docker, combiné aux NVIDIA Container Toolkit, permet d'isoler complètement l'environnement CUDA et de garantir la reproductibilité :

# Exemple d'utilisation d'une image PyTorch avec CUDA pré-configuré

docker run --gpus all -it pytorch/pytorch:2.1.0-cuda12.1-cudnn8-runtime

bash

Cette approche présente plusieurs avantages : pas de conflit avec d'autres installations, possibilité de tester différentes versions de CUDA, et déploiement simplifié en production. Les images officielles NVIDIA NGC (NVIDIA GPU Cloud) fournissent des environnements optimisés et testés pour les principaux frameworks d'IA.

Pour vérifier qu'une installation CUDA fonctionne correctement, quelques commandes permettent de diagnostiquer l'état du système :

# Vérifier le driver NVIDIA

nvidia-smi

# Vérifier la version de CUDA

nvcc --version

# Tester avec PyTorch

python -c "import torch; print(torch.cuda.is_available())"

bash

Conclusion

CUDA représente bien plus qu'une simple technologie d'accélération : c'est le socle fondamental sur lequel repose l'ensemble de l'écosystème moderne du deep learning et de l'IA générative. En permettant d'exploiter la puissance de calcul parallèle des GPU NVIDIA, CUDA a rendu possibles des avancées qui auraient été impensables il y a seulement une décennie.

Pour les praticiens de l'IA, comprendre CUDA n'est pas seulement une question technique, mais un atout stratégique. Savoir diagnostiquer un problème de compatibilité CUDA, optimiser l'utilisation de la VRAM, ou choisir le bon matériel en fonction des besoins représente des compétences précieuses dans un domaine où les ressources GPU sont souvent le facteur limitant.

Que vous développiez des applications de RAG, que vous fine-tuniez des modèles, ou que vous déployiez des LLM en production, CUDA sera invariablement présent dans votre stack technologique. Maîtriser ses fondamentaux vous permettra non seulement de résoudre les problèmes plus efficacement, mais aussi de tirer le meilleur parti de votre infrastructure pour des performances optimales.