LLM-as-a-Judge : définitions et exemples

L'évaluation des systèmes d'IA générative constitue l'un des défis les plus épineux auxquels font face les équipes qui déploient des solutions basées sur les LLM. Comment mesurer objectivement si une réponse est pertinente, fidèle aux sources, ou exempte d'hallucinations ? Les métriques traditionnelles héritées du traitement automatique des langues — BLEU, ROUGE, ou la simple correspondance de mots-clés — échouent à capturer les nuances sémantiques des textes générés par les modèles de langage modernes.

L'évaluation des systèmes d'IA générative constitue l'un des défis les plus épineux auxquels font face les équipes qui déploient des solutions basées sur les LLM. Comment mesurer objectivement si une réponse est pertinente, fidèle aux sources, ou exempte d'hallucinations ? Les métriques traditionnelles héritées du traitement automatique des langues — BLEU, ROUGE, ou la simple correspondance de mots-clés — échouent à capturer les nuances sémantiques des textes générés par les modèles de langage modernes.

Face à cette limitation, une approche contre-intuitive mais remarquablement efficace s'est imposée : utiliser des LLM pour évaluer d'autres LLM. C'est le principe du LLM-as-a-Judge (ou "LLM en tant que juge"), une méthodologie qui exploite les capacités de compréhension et de raisonnement des modèles de langage pour automatiser l'évaluation qualitative à grande échelle.

Dans cet article, nous allons explorer ce qu'est le LLM-as-a-Judge, comprendre pourquoi cette approche surpasse les méthodes traditionnelles, et découvrir comment l'appliquer concrètement pour évaluer les hallucinations, la fidélité aux sources et la pertinence des réponses dans vos systèmes d'IA générative.

Pourquoi les métriques traditionnelles ne suffisent plus

L'évaluation automatique des textes générés a longtemps reposé sur des métriques de comparaison lexicale. BLEU mesure le chevauchement de n-grammes entre une sortie et une référence, ROUGE évalue le rappel des séquences de mots. Ces approches, développées pour la traduction automatique et le résumé, partagent une faiblesse fondamentale : elles ignorent le sens pour ne considérer que la forme.

Prenons un exemple concret. Si un système RAG répond "L'entreprise a été créée en 1995" alors que la référence indique "La société a vu le jour en 1995", une métrique lexicale pénalisera lourdement cette réponse malgré son exactitude parfaite. À l'inverse, une réponse reprenant mot pour mot des éléments de la référence mais dans un contexte incohérent pourrait obtenir un bon score.

Les limites de ces approches deviennent critiques pour les systèmes d'IA générative modernes :

- Paraphrase et synonymie : les LLM excellent à reformuler, ce qui invalide les comparaisons mot à mot

- Réponses ouvertes : pour de nombreuses questions, plusieurs formulations correctes existent

- Nuances sémantiques : distinguer une information correcte d'une hallucination subtile nécessite une compréhension profonde

- Critères multidimensionnels : la qualité d'une réponse combine pertinence, fidélité, complétude et clarté

L'évaluation humaine reste l'étalon-or, mais elle présente des inconvénients majeurs : coût prohibitif, difficulté à passer à l'échelle, et variabilité entre annotateurs. C'est précisément dans cet espace que le LLM-as-a-Judge trouve sa place : offrir une évaluation sémantiquement riche avec la scalabilité de l'automatisation.

| Approche d'évaluation | Compréhension sémantique | Coût | Scalabilité | Reproductibilité |

|---|---|---|---|---|

| Métriques lexicales (BLEU, ROUGE) | ❌ Faible | ✅ Très bas | ✅ Excellente | ✅ Parfaite |

| Évaluation humaine | ✅ Excellente | ❌ Élevé | ❌ Limitée | ⚠️ Variable |

| LLM-as-a-Judge | ✅ Bonne | ⚠️ Modéré | ✅ Bonne | ⚠️ Dépend du prompt |

Le principe du LLM-as-a-Judge

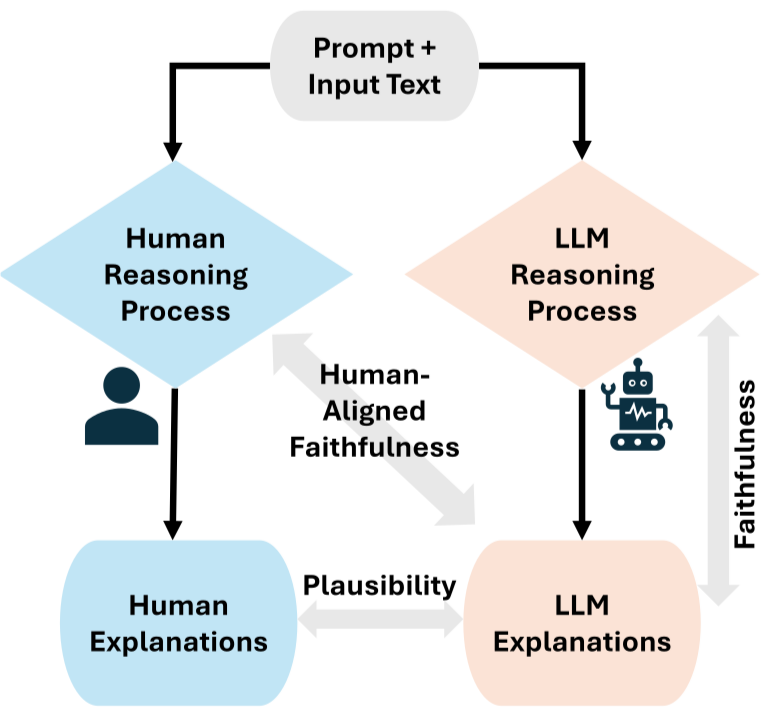

Le LLM-as-a-Judge repose sur une idée simple mais puissante : exploiter les capacités de raisonnement d'un LLM pour évaluer des sorties textuelles selon des critères définis. Le modèle "juge" reçoit un prompt structuré contenant les éléments à évaluer — typiquement une question, une réponse générée, et éventuellement des documents de contexte — ainsi que des instructions précises sur les critères d'évaluation.

Concrètement, le flux d'évaluation se décompose ainsi :

- Préparation du contexte : assembler la question posée, la réponse à évaluer, et les sources pertinentes

- Formulation du prompt d'évaluation : décrire précisément ce que le juge doit évaluer et comment

- Génération du verdict : le LLM analyse les éléments et produit une évaluation structurée

- Extraction du score : parser la sortie pour obtenir une métrique exploitable

L'efficacité de cette approche repose largement sur la qualité du prompt d'évaluation. Un prompt bien conçu explicite les critères, fournit des exemples de cas limites, et structure le format de sortie attendu. Voici un exemple simplifié pour évaluer la fidélité d'une réponse aux sources :

evaluation_prompt = """

Tu es un évaluateur expert chargé de vérifier si une réponse est fidèle aux documents sources fournis.

Documents sources :

{context}

Question posée : {question}

Réponse à évaluer : {answer}

Analyse chaque affirmation de la réponse et vérifie si elle peut être justifiée par les documents sources.

Évalue selon cette échelle :

- 1.0 : Toutes les affirmations sont fidèles aux sources

- 0.5 : Certaines affirmations sont fidèles, d'autres non vérifiables

- 0.0 : La réponse contient des informations contredisant les sources ou inventées

Fournis ton analyse puis ton score final au format : SCORE: [valeur]

"""

python

Cette approche présente plusieurs avantages distinctifs. Le LLM juge peut expliquer son raisonnement, facilitant le debugging et l'amélioration du système évalué. Il peut évaluer des critères subjectifs comme la clarté ou le ton. Et surtout, il capture des nuances sémantiques inaccessibles aux métriques automatiques traditionnelles.

Applications concrètes : évaluer hallucinations, fidélité et pertinence

Le LLM-as-a-Judge trouve ses applications les plus précieuses dans l'évaluation des systèmes RAG, où plusieurs dimensions de qualité doivent être mesurées simultanément.

Détection des hallucinations (Faithfulness)

L'hallucination — la génération d'informations non fondées sur les sources — constitue le risque majeur des systèmes d'IA générative en entreprise. Un LLM juge peut décomposer une réponse en affirmations individuelles et vérifier si chacune trouve un support dans le contexte fourni.

Le processus typique implique :

- Extraction des claims (affirmations factuelles) de la réponse

- Pour chaque claim, recherche d'une justification dans les documents sources

- Attribution d'un score binaire ou gradué selon le niveau de support

Cette évaluation permet d'identifier non seulement les réponses problématiques, mais aussi les types d'hallucinations récurrents : dates inventées, chiffres approximatifs transformés en valeurs précises, ou généralisations abusives.

Mesure de la groundedness

La groundedness (ancrage factuel) évalue dans quelle mesure une réponse s'appuie effectivement sur les informations récupérées. Contrairement à la fidélité qui vérifie l'absence de contradictions, la groundedness mesure le degré d'utilisation des sources.

Un LLM juge peut identifier :

- Les éléments de réponse directement issus des documents

- Les inférences légitimes dérivées des sources

- Les ajouts de connaissances générales du modèle (acceptables ou non selon le contexte)

- Les informations sans aucun ancrage dans le contexte fourni

Évaluation de la pertinence

La pertinence opère à deux niveaux dans un système RAG :

Context Relevance : les documents récupérés sont-ils pertinents pour la question ? Un juge LLM peut évaluer chaque chunk récupéré et déterminer s'il contribue réellement à répondre à la question posée. Un score bas indique un problème au niveau du retriever.

Answer Relevance : la réponse répond-elle à la question posée ? Une réponse peut être parfaitement fidèle aux sources tout en étant hors sujet. Le juge évalue l'alignement entre l'intention de la question et le contenu de la réponse.

# Exemple d'évaluation multi-critères avec un LLM juge

def evaluate_rag_response(question, answer, contexts, llm_judge):

metrics = {}

# Évaluation de la fidélité

metrics["faithfulness"] = llm_judge.evaluate(

criterion="faithfulness",

question=question,

answer=answer,

contexts=contexts

)

# Évaluation de la pertinence de la réponse

metrics["answer_relevancy"] = llm_judge.evaluate(

criterion="relevancy",

question=question,

answer=answer

)

# Évaluation de la pertinence du contexte

metrics["context_precision"] = llm_judge.evaluate(

criterion="context_relevance",

question=question,

contexts=contexts

)

return metrics

python

À découvrir : notre formation LLM Engineering

RAGAS et les frameworks d'évaluation

Implémenter un système LLM-as-a-Judge from scratch demande un travail conséquent : conception des prompts d'évaluation, gestion des cas limites, parsing des sorties, calibration des scores. Heureusement, des frameworks spécialisés encapsulent ces bonnes pratiques et permettent de démarrer rapidement.

RAGAS (Retrieval Augmented Generation Assessment) s'est imposé comme la référence open source pour l'évaluation des systèmes RAG. Cette librairie Python implémente un ensemble de métriques LLM-as-a-Judge spécifiquement conçues pour les pipelines de génération augmentée :

- Faithfulness : vérifie que chaque affirmation de la réponse peut être inférée du contexte

- Answer Relevancy : mesure si la réponse adresse effectivement la question

- Context Precision : évalue la proportion de documents récupérés réellement utiles

- Context Recall : vérifie que les informations nécessaires ont été récupérées

L'utilisation de RAGAS est remarquablement simple :

from ragas import evaluate

from ragas.metrics import faithfulness, answer_relevancy, context_precision

from datasets import Dataset

# Préparation des données d'évaluation

eval_data = {

"question": ["Quelle est la politique de retour ?"],

"answer": ["Les retours sont acceptés sous 30 jours..."],

"contexts": [["Document 1...", "Document 2..."]],

"ground_truth": ["La politique permet les retours sous 30 jours..."]

}

dataset = Dataset.from_dict(eval_data)

# Évaluation avec RAGAS

results = evaluate(

dataset=dataset,

metrics=[faithfulness, answer_relevancy, context_precision]

)

print(results)

# {'faithfulness': 0.92, 'answer_relevancy': 0.88, 'context_precision': 0.75}

python

RAGAS permet également de choisir le modèle juge selon vos contraintes. Pour des données sensibles, l'intégration avec Ollama permet une évaluation entièrement locale. Pour une qualité d'évaluation maximale, les API d'OpenAI ou Anthropic restent recommandées.

D'autres outils méritent mention : DeepEval propose des métriques similaires avec une API différente, TruLens offre des capacités de tracing en plus de l'évaluation, et LangSmith de LangChain intègre des fonctionnalités de LLM-as-a-Judge dans une plateforme d'observabilité plus large.

| Framework | Points forts | Cas d'usage idéal |

|---|---|---|

| RAGAS | Métriques RAG complètes, bien documenté | Évaluation systématique de pipelines RAG |

| DeepEval | Interface pytest-like, CI/CD friendly | Tests automatisés en intégration continue |

| TruLens | Tracing + évaluation combinés | Debugging et monitoring en développement |

| LangSmith | Écosystème LangChain intégré | Projets utilisant déjà LangChain |

Bonnes pratiques et limites

L'adoption du LLM-as-a-Judge nécessite une compréhension claire de ses forces et de ses limites pour en tirer le meilleur parti.

Choisir le bon modèle juge impacte directement la qualité de l'évaluation. Les modèles les plus capables (GPT-4o, Claude 3.5 Sonnet) produisent des évaluations plus fiables mais à un coût supérieur. Pour des évaluations fréquentes en développement, un modèle plus léger peut suffire, en réservant les modèles premium aux benchmarks critiques.

Calibrer et valider les évaluations reste essentiel. Avant de faire confiance aveuglément aux scores LLM-as-a-Judge, constituez un petit ensemble de données évaluées manuellement et vérifiez la corrélation avec les jugements automatiques. Cette validation permet d'identifier les biais éventuels du juge et d'ajuster les prompts en conséquence.

Documenter les critères d'évaluation garantit la reproductibilité. Les prompts utilisés, les seuils de décision, et les modèles employés doivent être versionnés au même titre que le code. Un score de faithfulness de 0.85 n'a de sens que si l'on sait précisément comment il a été calculé.

Les limites de l'approche méritent attention :

- Biais du modèle juge : un LLM peut avoir des préférences stylistiques ou favoriser certains types de réponses

- Coût à l'échelle : évaluer des milliers d'exemples avec GPT-4 représente un budget non négligeable

- Circularité potentielle : utiliser le même modèle pour générer et évaluer peut masquer certains problèmes

- Variabilité : contrairement aux métriques déterministes, les scores peuvent légèrement varier entre exécutions

Conclusion

Le LLM-as-a-Judge représente une avancée majeure dans l'évaluation des systèmes d'IA générative. En exploitant les capacités de compréhension des modèles de langage, cette approche comble le fossé entre les métriques automatiques superficielles et l'évaluation humaine coûteuse et non scalable.

Pour les équipes qui construisent des systèmes RAG, des chatbots d'entreprise ou des assistants spécialisés, intégrer une évaluation LLM-as-a-Judge n'est plus optionnel mais indispensable. La capacité à mesurer objectivement la fidélité aux sources, à détecter les hallucinations et à évaluer la pertinence des réponses constitue le socle d'une amélioration continue et d'une mise en production sereine.

Des frameworks comme RAGAS démocratisent cette approche en proposant des implémentations prêtes à l'emploi, testées et documentées. Plutôt que de réinventer la roue, les équipes peuvent se concentrer sur l'amélioration de leurs pipelines en s'appuyant sur des métriques fiables et standardisées.

L'évaluation par LLM n'est pas parfaite — aucune méthode ne l'est — mais elle offre aujourd'hui le meilleur compromis entre qualité sémantique, coût et passage à l'échelle. Maîtriser cette approche devient un atout stratégique pour quiconque développe des applications d'IA générative où la fiabilité des réponses conditionne la confiance des utilisateurs et la valeur métier délivrée.